You can use Crawlability Checker which effectively checks if the search engine crawlers can access and crawl a URL or not. It performs a simple crawlability test to validate the crawlability of web page links.

Crawlability Checker

Check the crawlability and indexability status of any website or web page!

Features

Check Website Crawlability

Monitor Indexability Status

View and Validate Robots.txt File

Related Tools

ETTVI’s Crawlability Test tool

Check if website is crawlable and indexable by different search engine crawlers or not in real-time. ETTVI’s Crawlability Checker examines the Robots.txt file to determine the crawlability and indexability status of a link. Specify a URL to check whether the search engine crawlers are allowed to access it for crawling and indexing.

ETTVI’s Crawlability Tester lets you validate the Robots Meta Directives which provide crawl instructions to Googlebot and Bingbot. The webmasters can easily leverage this effective SEO tool to view the Robots.txt file of a website and monitor how it controls the behavior of the crawlers.

For quick indexing and ranking, ensure that you have properly set the crawl instructions and your links successfully pass the crawlability test. In case you want to save your crawl budget or don't want to index your private pages then audit your Robots.txt file with this efficient tool to make sure that bots are disallowed from crawling your specified directories.

Perform a quick crawlability and indexability test with ETTVI’s easy-to-use tool for free of cost.

How to Use ETTVI’s Crawlability Test Tool?

Follow these simple steps for a quick crawlability check:

STEP 1 - Enter URL

Specify the link to the web page whose crawlability and indexability status you would like to check as follows:

STEP 2 - Run the Tool

Click on “Check” to run ETTVI’s Crawlability Test Tool.

STEP 3 - Check Results

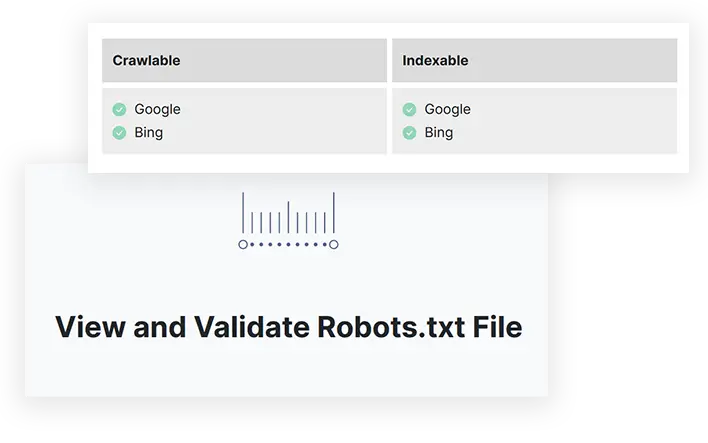

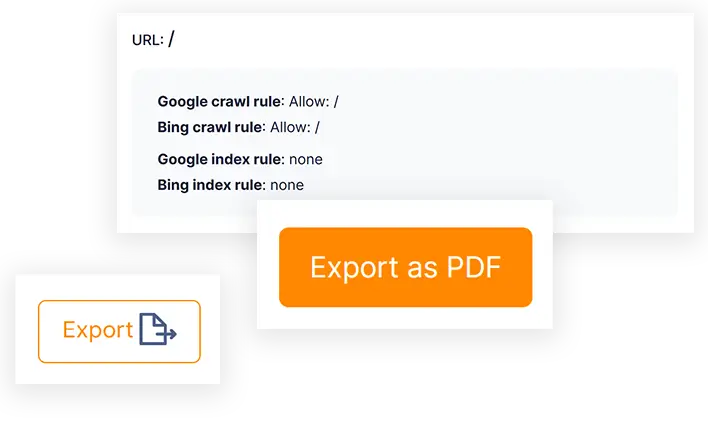

ETTVI’s Crawlability Checker will provide you with crawlability test report which will enable you to:

➞ Check Crawlability Status

(It will highlight whether Google and Bing are allowed or disallowed to crawl the given URL)

➞ Monitor Indexability Status

(It will show whether Google and Bing are allowed or disallowed to index the given URL)

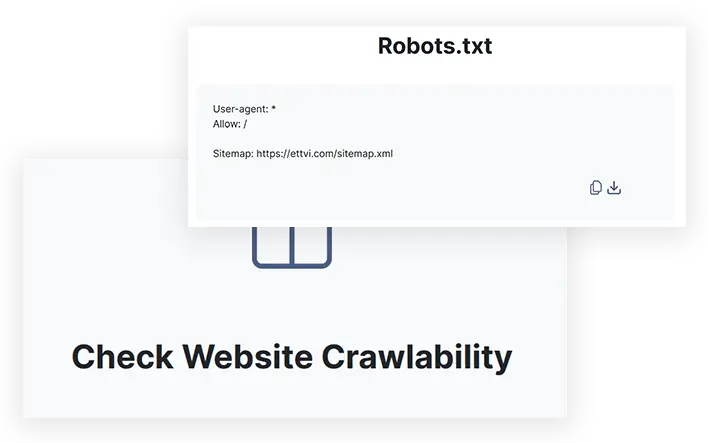

➞ Analyze Robots.txt

(It will display the Robots.txt file and link to the XML Sitemap of the respective website)

Why Use ETTVI’s Crawlability Checker?

Crawlability denotes search engine’s capacity of accessing & crawling web page contents. By using ETTVI’s Crawlability Test tool, you can find it within a few seconds.

There's a lot more which the webmasters can do with this advanced tool including:

Identify Crawlability Issues

In order to increase the efficiency of webmasters, ETTVI has created The Crawlability Checker which takes less than a few seconds to determine if a web page is crawlable or not. The users can easily find out whether the major search engines including Google and Bing can crawl the given URL or not. This way, it helps the best to discover the crawlability problems.

Indeed, the webmasters would never like it if the search engine is unable to access and crawl the most important pages of their site. Therefore, they can leverage ETTVI's Crawlability Test Tool to ensure that there are no crawlability mistakes and errors.

Check Indexability Status

It quickly analyzes the given links to check indexability and crawlability status. Just as the user enters a URL, it thoroughly checks the specified crawl instructions to find out if Google and Bing are allowed to index it or not. This way, the webmasters can easily monitor the indexable links as well as expose the URLs which can not be indexed.

For sure, indexability is crucial for ranking and the webmasters need to make sure that all of the important links of their site are indexable - thus, ETTVI's Crawlability & Indexability Checker serves the best.

Analyze Robots Directives

ETTVI's Crawl Errors Checker is an advanced tool which performs multiple functions at a time. Other than checking crawlability and indexability status, the webmasters can use it to track the Robots.txt file of any website.

As the user enters a URL to test the crawlability and indexability, ETTVI's tool fetches, analyzes, and displays the respective site's Robots.txt file as well. Just like Google robots tester, ETTVI’s tool serves as a meta robots checker to makes it easier for the webmasters to monitor and validate the specified crawl instructions (robots meta directives).

Find XML Sitemap

Just as ETTVI's advanced Crawl Checker provides the user with the Robots.txt file, it also displays the link to the respective site's XML Sitemap.

It enables the users to double-check the sitemap and make sure whether they have enlisted all the important URLs for crawling or not. Moreover, it helps to validate that all of website URLs have a crawlable link structure.

Understanding Crawlability and Indexability

Have you ever thought about how search engines find the web content and serve it to the users on the search result pages? This is done through a 3-step process: crawling, indexing, and ranking.

First of all, let us provide you with quick insights into the search engines crawl and index the websites.

What is Crawling and Indexing?

Crawling meaning can be best defined as “the process in which search engine robots discover new and updated web pages”. Keep in mind that the search engine is “Google” whereas the search engine robots are “the team of crawlers which find and assess the web content for indexing”.

Here comes the point where you will understand indexing: the process in which the search engine stores the website pages in its server database. The search engine crawlers are primarily built to keep looking for web content which needs to be indexed.

For instance, you have published a new page on your website but can internet users find it right away? For sure, the users will not be able to search for it until or unless the search engine crawls it and indexes it.

Once the search engine crawlers find your website, they go from one page to another page in order to assess your content quality and make sure that your web pages are well-optimized to be indexed.

What if the search engine is unable to access your web pages? In case it happens then your content will not be crawled. Certainly, neither you can index nor rank your web pages without crawling. Likewise, if a search engine can crawl your web pages but is unable to index them then you should forget about ranking.

Whenever you publish new content, you need to make sure - is my site crawlable?

Keeping all this in view, you can understand that all the important URLs of your website must be crawlable and indexable.

Now, we would like to move forward and provide you with in-depth details about crawlability and indexability of URLs.

What is Crawlability and Indexability?

The ability of a search engine to find, access, and crawl the web content is marked as crawlability whereas the search engine’s to store the web content into its database is referred to as indexability.

This is the point where you will understand what it means for a URL to be crawlable and indexable. Take in account that the crawlability status of a URL highlights whether it is crawlable while the indexability status shows whether it is indexable.

There’s no doubt that there’s a very significant part and role of crawlability in SEO. All the SEO experts know that the search engine crawler has enabled us to specify the crawl instructions in order to control the crawlability and indexability of web pages. Using the Robots.txt file, we can easily allow or disallow search engine robots from crawling and indexing certain pages. Usually, the robots are disallowed from crawling and indexing the unimportant pages. However, there can be instances when the search engine robots fail to crawl or index the most important pages of our website, causing a drastic decrease in the rankings. This is where the trouble begins:

despite being allowed, the search engine robots will not be able to access, assess, and store the web content.

We hear many people asking questions like ” how to check if google can crawl my site” or “how to check if my website is crawlable” when they don’t know how to track crawlable links. So, if you also don’t know how to check site crawlability then take a note: you can leverage ETTVI’s Crawlability Checker to perform a free crawling test and check if website is indexable/crawlable or not within seconds.

What Affects Crawlability and Indexability?

If you want to know how to make your site crawlable and indexable then you need to be aware of the factors which affect the URL crawlability and indexability. Let's discuss these factors one by one so that you can properly understand your crawlability mistakes:

➞Robots Meta Directives

We can set the robots meta directives to provide the search engine crawlers with instructions about how they should crawl a website page. If we specify a “disallow” directive for a URL in the Robots.txt file then the search engine will not be able to access it. Moreover, if we specify “noindex” directive for a URL then the search engine won’t index it even despite crawling. This means that the robots meta directives have a direct impact on crawling and indexing.

Be cautious and careful while specifying crawl instructions in the Robots.txt file as a single error can badly affect the crawlability and indexability of website URLs.

(you can use ETTVI's Crawlability Checker as an effective Robots.txt Testor to make sure that you have set the robots directives in the right way)

➞ Website Architecture

A website with easy-to-navigate structure is all that the search engine requires. If your website structure hasn’t been hierarchically organized and internally linked then the search engine crawlers will not be able to crawl your URLs properly. Imagine that the crawler is moving through your website but it doesn’t find any link to jump from one page to another relevant page. This will leave the crawler with nothing but a dead end which means that the crawler will return without crawling your website properly.

Always make sure that your website architecture is optimized enough to make the crawling and indexing easier.

➞Broken Links

Internal and external links which are broken (can not be opened or loaded) can cause major crawlability issues. For instance, the crawler is visiting your site but suddenly it comes across a dead link which leads it to nothing. Unfortunately, the broken link redirects prevent the crawlers from crawling, probably making them leave the crawling halfway.

If you want a crawlable website then make sure that there are no dead links on your pages and all of your important links are crawlable (accessible by robots). You should do a regular crawl check to avoid any crawlability and indexability problems.

➞Server Errors

Remember that not only broken link errors but other server errors can also stop the crawler from crawling your pages. Therefore, you need to make sure that your server is not down and your pages are loading properly.

Tip: Use ETTVI's Crawlability Test Tool which works as an effective crawl error checker to find out which link is crawlable and which link is not crawlable.

How to Check if a Website is Crawlable?

There's a majority of beginner webmasters who often ask questions like "is my website crawlable" , " is my page crawlable", or "how to check if page is crawlable". Unfortunately, only a few know the right way to find the right answers to these questions.

In order to check if site is crawlable, you are required to test website crawlability which can be done via ETTVI's Crawlability Checker. It will carry out a quick website crawl test.

Just specify your web page link and run the tool. It will take only a few seconds to perform a crawl test and let you know if search engine crawlers can access, crawl, and index the given link or not.

For the record, ETTVI’s Crawlability Checker doesn’t require you to pay any premium charges to check if a website can be crawled and indexed or not.

How Can I Check If a Page is Indexable?

If you search on the web as “is my site indexable” then you’ll find multiple links to a variety of google indexation tester tools. For sure, there are many ways to check your site indexability such as Google crawlability test. However, not every other crawler can perform an accurate and quick search engine crawler test.

If you want the right and quick answer to “is my website indexable” then you can use ETTVI’s Google Crawler Checker which also works as an efficient Indexable Checker. You can easily carry out a website crawl test to check if the search engine can access, crawl,and index your links or not. This is the best and easiest way to check if site is indexable or not - for free of cost.

Frequently Ask Questions

How to Check if URL is Crawlable?

What ETTVI's Crawlability Checker Do?

ETTVI's Crawlability Test Tool carries out an in-depth test to check the crawlability and indexability of any web page link. It enables the users to find out if the major search engine crawlers including Googlebot and Bingbot can crawl/index a link or not. Moreover, working as a Robots.txt Checker, it provides the users with the Robots.txt file and a link to XML Sitemap of the given website as well.

How Can We Make a Website Easier to Crawl and Index?

Optimize crawlability by creating an XML sitemap, improving internal linking, using clean URLs, and avoiding unnecessary redirects. Ensure robots.txt and meta tags do not block important pages, allowing search engines to crawl efficiently.

Is ETTVI's Crawlability Test Report Valid?

ETTVI's Crawlability Checker effectively performs a quick-test to check the crawlability and indexability of any web link. Its crawlability test report is 100% accurate and valid.

How Do I Check If a Site Can Be Crawled?

Use a crawler tool like Screaming Frog or Google’s URL Inspection tool. Verify robots.txt, meta tags, and server responses to ensure search engines can access and index critical pages without restrictions.

What Can a Search Engine See?

Search engines see text content, metadata, links, structured data, and images with alt text. However, they may struggle with JavaScript-heavy elements, blocked resources, or dynamically loaded content, affecting indexing and rankings.

Stay up to date in the email world.

Subscribe for weekly emails with curated articles, guides, and videos to enhance your tactics.