Robots.txt — это файл, который размещается в корневом каталоге. Он используется для указания сканеру поисковой системы по сканированию и индексированию сайта . Это может быть полезно или может быть опасно в зависимости от того, как вы его используете.

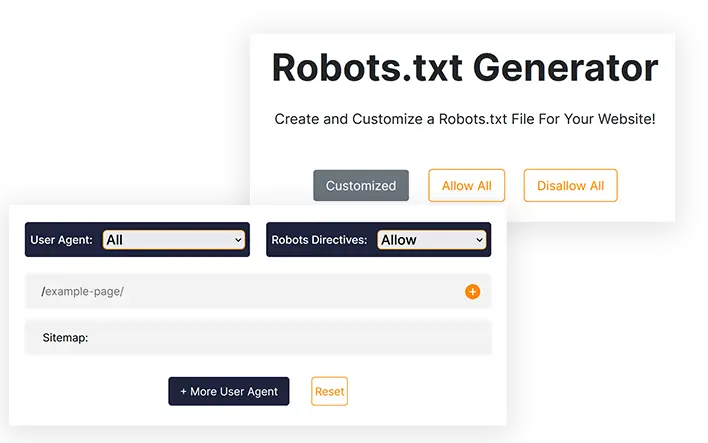

Генератор robots.txt

Создайте и настройте файл Robots.txt для своего веб-сайта!

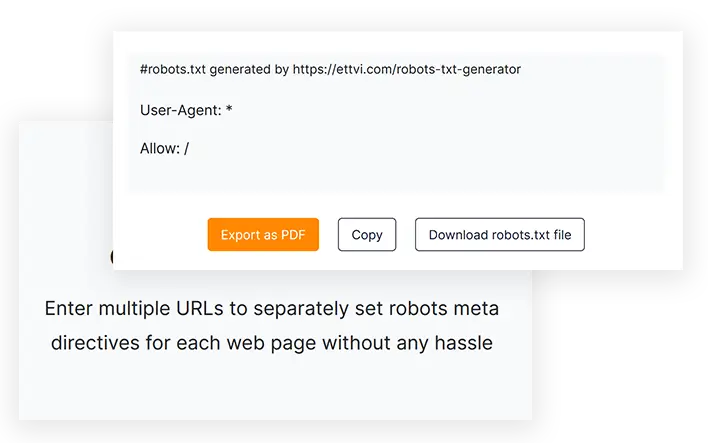

#robots.txt создан https://ettvi.com/robots-txt-generator

User-Agent: *

Allow: /

| Customized |

|---|

| Allow |

|---|

| Disallow |

|---|

Функции

Создать файл Robots.txt

Создайте файл robots.txt для своего веб-сайта или веб-страниц, чтобы указать инструкции сканирования без каких-либо ошибок в кодировании.

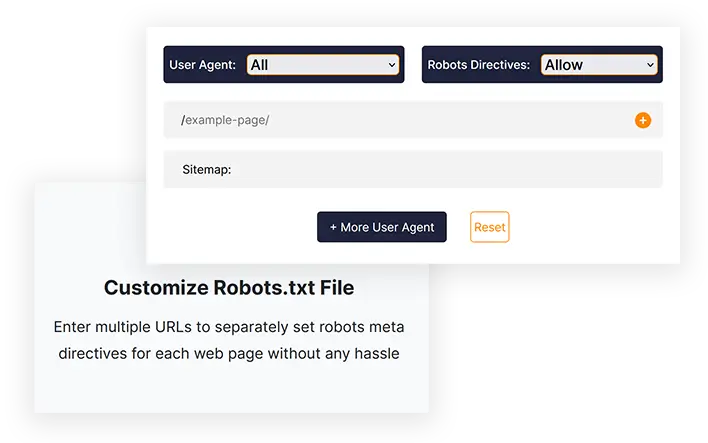

Настройка файла Robots.txt

Введите несколько URL-адресов, чтобы без каких-либо проблем отдельно установить мета-директивы роботов для каждой веб-страницы.

Экспорт в один клик

Скопируйте код robots.txt или загрузите файл robots.txt напрямую и загрузите его в корневой каталог вашего веб-сайта.

Связанные инструменты

Генератор Robots.txt от ETTVI

Создайте файл Robots.txt для своего веб-сайта, чтобы определить поведение сканеров поисковых систем с помощью генератора Robots.txt от ETTVI. Веб-мастера могут использовать этот инструмент для создания стандартного файла Robots.txt с настройками по умолчанию или настроить его для установки конкретных инструкций по сканированию для различных веб-страниц.

Воспользуйтесь расширенными функциями генератора Robots.txt от ETTVI, чтобы ограничить сканирование каталога или скрыть ваши личные страницы от сканера.

Отдельно включите мета-директивы robots для каждого URL-адреса, чтобы указать, что и как сканеры могут получить доступ к соответствующим ссылкам, не тратя впустую свой краулинговый бюджет. Разрешите или запретите различным сканерам поисковых систем сканировать ваш веб-контент по мере необходимости.

Программа Robots.txt Creator от ETTVI эффективно обрабатывает предоставленную информацию для указания инструкций сканирования без каких-либо ошибок в кодировании. Сообщите сканерам, как им следует сканировать и индексировать ваши веб-страницы с помощью бесплатного генератора Robots.txt от ETTVI.

Как использовать генератор Robots.txt от ETTVI?

Генератор Robots.txt от ETTVI позволяет пользователям создавать файл Robots.txt по умолчанию с инструкциями сканирования «Все разрешать» или «Все запрещать», а также создавать собственный файл Robots.txt с дополнительными функциями.

Создайте стандартный файл Robots.txt

Выполните следующие действия, чтобы создать стандартный файл Robots.txt с настройками по умолчанию:

ШАГ 1. Установите мета-директивы роботов

Вы можете установить директивы разрешения/запрета для «всех роботов поисковых систем», чтобы они создавали стандартный файл robots.txt. Выберите «Разрешить» или «Запретить», чтобы применить настройки по умолчанию:

ШАГ 2. Введите адрес карты сайта.

Введите ссылку на карту сайта вашего сайта или оставьте ее пустой, если у вас ее нет.

Вы можете ввести более одной карты сайта для конкретных категорий страниц, сообщений, категорий и тегов вашего веб-сайта.

ШАГ 3 — Получите код Robots.txt

Как только вы вводите необходимую информацию, генератор Robots.txt от ETTVI автоматически генерирует и отображает код Robots.txt.

Вы можете скачать или скопировать код, чтобы отправить файл Robots.txt в корневой каталог вашего веб-сайта.

Создать индивидуальный файл Robots.txt

Выполните следующие действия, чтобы создать стандартный файл Robots.txt с настройками по умолчанию:

Введите URL-адреса:

ШАГ 2. Выберите пользовательский агент.

Вы можете установить директивы мета-роботов для любого из следующих пользовательских агентов:

- Google Image

- Google для мобильных устройств

- MSN-поиск

- Yahoo

- Yahoo ММ

- Блоги Yahoo

- Байду

- MSN PicSearch

Вы можете выбрать разные пользовательские агенты для разных URL-адресов.

ШАГ 3. Разрешить/запретить роботов поисковых систем

Выберите «Разрешить или запретить», чтобы установить мета-директивы роботов для заданных URL-адресов.

Вы можете отдельно установить директиву «Разрешить» или «Запретить» для каждого URL-адреса.

Зачем использовать генератор Robots.txt от ETTVI?

Robots.txt — это файл, который используется для указания сканеру поисковой системы, какие URL-адреса можно сканировать или индексировать, а какие нет. Файл robots.txt очень важен и полезен для веб-мастеров, и каждый эксперт по SEO использует robots.txt для разных целей.

Однако, если он написан неправильно, это может вызвать проблемы с индексацией вашего сайта, и Google не сможет правильно просканировать ваш сайт. Используя генератор Robots.txt от ETTVI, вы можете сгенерировать точный файл, а не писать код вручную, всего одним щелчком мыши.

Быстрое создание файла Robots.txt

Генератор Robots.txt может избавить вас от любой ошибки кодирования и сэкономить много времени, которое вы можете применить к другим задачам SEO, таким как создание карты сайта. Большинство экспертов по SEO рекомендуют генератор Robots.txt от ETTVI, потому что это эффективный, быстрый и бесплатный инструмент, который в кратчайшие сроки создаст ваш robots.txt в соответствии с вашими потребностями.

Скрыть частные страницы

Предположим, у вас есть личная страница, которую вы хотите показывать только подписанным людям, но если она будет проиндексирована, ее смогут увидеть все. Итак, чтобы избежать этой проблемы, вам нужно запретить ваши личные страницы в robots.txt.

Экономьте бюджет сканирования

Если у вас много дополнительных страниц (например, тегов), они могут нарушить ваш краулинговый бюджет и вызвать проблемы с индексацией. Поэтому мы запрещаем дополнительные страницы в robots.txt, чтобы избежать этой проблемы.

Понимание файла Robots.txt?

Файл Robots.txt — это текстовый файл, содержащий информацию о том, как сканер должен сканировать веб-сайт. Кроме того, вы можете указать, к каким областям вы не хотите открывать доступ сканерам, например, к областям с повторяющимся контентом или к областям, находящимся в разработке. Есть некоторые боты, которые не соответствуют этому стандарту, в том числе детекторы вредоносного ПО и сборщики электронной почты. В результате они будут искать слабые места в вашей системе безопасности. Если вы не хотите, чтобы определенные разделы индексировались, существует реальная вероятность того, что ваш веб-сайт начнут просматривать именно из этих разделов.

Обычно существует два файла Robots.txt: один содержит «Агент пользователя», а другой содержит директивы «Разрешить», «Запретить», «Задержка сканирования» и т. д. Написание файла командных строк вручную может занять довольно много времени. долгое время, и файл может содержать несколько строк команд одновременно. На следующей странице вам следует написать «Запретить: ссылку, которую боты не хотят посещать». Тот же метод применим и к команде «разрешить».

Почему файл robots.txt важен?

Файлы Robots.txt не требуются большинству веб-сайтов. В результате Google часто может без труда найти все важные страницы вашего сайта и проиндексировать их. И они не будут индексировать неважные страницы или дубликаты уже проиндексированных страниц.

Однако есть три основные причины использования файла robots.txt.

Запретить просмотр закрытых страниц. Иногда вы не хотите, чтобы определенные страницы индексировались на вашем сайте. Например, у вас могут быть промежуточные версии определенных страниц или страницы входа. Крайне важно, чтобы эти страницы существовали и на них не перенаправлялись случайные пользователи. Таким образом, файл robots.txt следует использовать для блокировки доступа сканеров и ботов к этим страницам.

Максимально используйте свой краулинговый бюджет. Если у вас возникли трудности с индексацией страниц, может возникнуть проблема с краулинговым бюджетом. Когда вы используете robots.txt для блокировки неважных страниц, робот Googlebot будет проводить больше времени на действительно важных веб-страницах.

Ресурсы не должны индексироваться. Вы можете использовать метадирективы, чтобы предотвратить индексацию страницы так же эффективно, как и при использовании файла Robot.txt. Однако метадирективы плохо работают с мультимедийными ресурсами, такими как PDF-файлы и изображения. В этом случае файл robots.txt будет полезен.

Когда роботы поисковых систем проверяют файлы, они сначала ищут файл robots.txt, и если этот файл не найден, существует значительная вероятность того, что все страницы вашего сайта не будут проиндексированы. Когда вы добавляете больше страниц, вы можете изменить файл Robot.txt с помощью нескольких инструкций, добавив главную страницу в список запрещенных. Однако избегайте добавления главной страницы в список запрещенных в начале файла.

Существует бюджет на сканирование веб-сайта Google; этот бюджет определяется лимитом сканирования. Как правило, сканеры проводят на веб-сайте определенное количество времени, прежде чем перейти к следующему, но если Google обнаружит, что сканирование вашего сайта беспокоит ваших пользователей, он будет сканировать ваш сайт медленнее. Из-за более медленного сканирования вашего веб-сайта Google, он будет индексировать только несколько страниц вашего сайта за раз, поэтому для полной индексации вашей последней публикации потребуется время. Для решения этой проблемы необходимо, чтобы на вашем сайте была карта сайта и файл robots.txt. Процесс сканирования можно ускорить, если направить их на ссылки вашего сайта, требующие особого внимания, чтобы ускорить процесс сканирования.

Помимо скорости сканирования веб-сайта, каждый бот имеет свою уникальную цену сканирования. Вот почему вам нужен файл робота для вашего сайта WordPress. Это связано с тем, что он состоит из большого количества страниц, которые не нужны для индексации. Более того, если вы решите не включать файл robots.txt, сканеры все равно будут индексировать ваш веб-сайт, но если это не очень большой блог и не содержит много страниц, в этом нет необходимости.

Назначение директив в файле Robot.txt:

При создании файла руководства крайне важно знать, как его следует форматировать. Кроме того, узнав, как это работает, вы можете изменить его.

Задержка времени сканирования: установив эту директиву, сканеры не будут перегружать сервер, поскольку слишком большое количество запросов приведет к перегрузке сервера, что не приведет к оптимальному взаимодействию с пользователем. Различные боты поисковых систем по-разному реагируют на директиву Crawl-Delay. Например, Bing, Google и Яндекс реагируют по-разному.

Разрешение: используя эту директиву, мы разрешаем индексацию следующих URL-адресов. Независимо от количества URL-адресов, которые вы можете добавить в свой список, если у вас есть веб-сайт электронной коммерции, вам может потребоваться добавить много URL-адресов. Если вы все же решите использовать файл robots, вам следует использовать его только для тех страниц, которые вы не хотите индексировать.

Запрет: одной из наиболее важных функций файла Robots является предотвращение доступа сканеров к ссылкам, каталогам и т. д. внутри него. Однако другие боты могут получить доступ к этим каталогам, а это означает, что им придется проверять наличие вредоносных программ, поскольку они не соответствуют требованиям.

Разница между файлом Sitemap и файлом Robot.txt

Карта сайта содержит ценную информацию для поисковых систем и необходима для всех веб-сайтов. Файлы Sitemap сообщают ботам, когда ваш сайт обновляется, а также о том, какой тип контента он предлагает. Цель страницы — информировать поисковую систему обо всех страницах вашего сайта, которые следует сканировать, а цель файла robots.txt — уведомить сканер. С помощью Robot.txt сканерам сообщают, какие страницы сканировать, а какие избегать. Чтобы ваш сайт был проиндексирован, вам понадобится карта сайта, тогда как robot.txt не требуется.

Часто задаваемые вопросы

Что такое файл Robots.txt?

Что такое генератор Robots.txt?

Генератор Robots.txt — это онлайн-инструмент, позволяющий веб-мастерам создавать файлы robots.txt в соответствии со своими потребностями без ручного написания кода.

Нужен ли файл Robots.txt?

Нет, файл robots.txt не обязателен, но с его помощью вы можете контролировать сканеры поисковых систем. Большинство экспертов рекомендуют иметь на вашем сайте файл robots.txt.

Как создать файл Robots.txt?

Вы можете создать его, написав код вручную, но это слишком опасно и может вызвать проблемы с индексацией. Итак, лучшее решение этой проблемы — использовать генератор Robots.txt, такой как Ettvi. Генератор Robots.txt от Ettvi позволяет бесплатно создать собственный файл.

Как проверить, хороший ли мой файл Robots.txt?

После создания и размещения файла Robots.txt возникает главный вопрос: как проверить файл robots.txt? Вы можете легко проверить свой файл с помощью инструмента проверки ETTVI Robots.txt.

Будьте в курсе событий в мире электронной почты.

Подпишитесь на еженедельные электронные письма с тщательно подобранными статьями, руководствами и видео, чтобы улучшить свою тактику.