Robots.txt è un file che viene inserito nella directory principale: viene utilizzato per fornire istruzioni al crawler del motore di ricerca sulla scansione e l'indicizzazione del sito . Può essere utile o può essere pericoloso a seconda del modo in cui lo si utilizza.

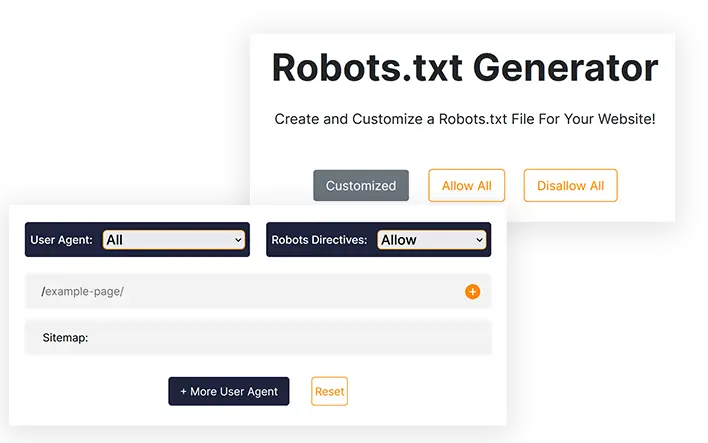

Generatore Robots.txt

Crea e personalizza un file Robots.txt per il tuo sito web!

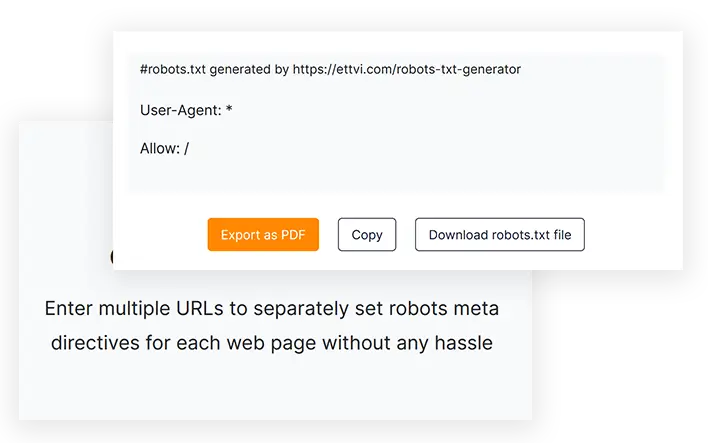

#robots.txt generato da https://ettvi.com/robots-txt-generator

User-Agent: *

Allow: /

| Customized |

|---|

| Allow |

|---|

| Disallow |

|---|

Caratteristiche

Genera il file Robots.txt

Crea un file robots.txt per il tuo sito web o le tue pagine web per specificare le istruzioni di scansione senza errori di codifica

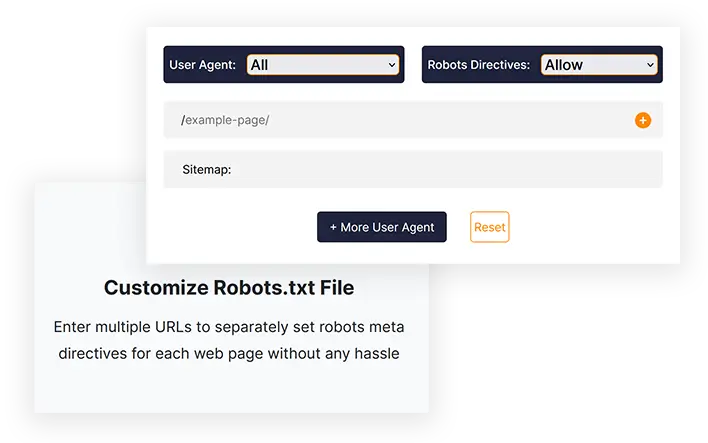

Personalizza il file Robots.txt

Inserisci più URL per impostare separatamente le meta direttive dei robot per ciascuna pagina web senza problemi

Esporta con un clic

Copia il codice robots.txt o scarica direttamente il file robots.txt da caricare nella directory principale del tuo sito web

Strumenti correlati

Generatore Robots.txt di ETTVI

Crea il file Robots.txt per il tuo sito web per determinare il comportamento dei crawler dei motori di ricerca con il generatore Robots.txt di ETTVI. I webmaster possono sfruttare questo strumento per generare un file Robots.txt standard con impostazioni predefinite o personalizzarlo per impostare istruzioni di scansione specifiche per diverse pagine web.

Sfrutta le funzionalità di livello avanzato del generatore Robots.txt di ETTVI per limitare la scansione di una directory o nascondere le tue pagine private al crawler.

Includi separatamente meta direttive robots per ciascun URL per indicare cosa e come i crawler possono accedere ai rispettivi collegamenti senza sprecare il budget di scansione. Consenti o impedisci a diversi crawler dei motori di ricerca di eseguire la scansione dei tuoi contenuti web come richiesto.

Robots.txt Creator di ETTVI elabora efficacemente le informazioni fornite per specificare le istruzioni di scansione senza alcun errore di codifica. Informa i crawler su come dovrebbero scansionare e indicizzare le tue pagine web con il generatore Robots.txt di ETTVI gratuitamente.

Come utilizzare il generatore Robots.txt di ETTVI?

Il generatore Robots.txt di ETTVI consente agli utenti di generare un file Robots.txt predefinito con le istruzioni di scansione "Tutto consentito" o "Tutto non consentito", nonché di creare un file Robots.txt personalizzato con funzionalità aggiuntive.

Genera un file Robots.txt standard

Seguire questi passaggi per generare un file Robots.txt standard con le impostazioni predefinite:

PASSO 1: imposta le meta direttive dei robot

Puoi impostare direttive di autorizzazione/disautorizzazione per "tutti i robot dei motori di ricerca" per generare un file robots.txt standard. Scegli "Consenti" o "Non consentire" per applicare le impostazioni predefinite:

PASSO 2 - Inserisci l'indirizzo della mappa del sito

Inserisci il collegamento alla mappa del sito del tuo sito web o lascialo vuoto se non ne hai nessuno.

Puoi inserire più di una mappa del sito specifica per categoria delle pagine, dei post, delle categorie e dei tag del tuo sito web.

PASSO 3: Ottieni il codice Robots.txt

Non appena inserisci le informazioni richieste, il generatore Robots.txt di ETTVI genera e visualizza automaticamente il codice Robots.txt.

Puoi scaricare o copiare il codice per inviare il file Robots.txt alla directory principale del tuo sito web.

Genera file Robots.txt personalizzato

Seguire questi passaggi per generare un file Robots.txt standard con le impostazioni predefinite:

Inserisci gli URL:

PASSO 2: seleziona Agente utente

Puoi impostare le direttive meta robots per uno qualsiasi dei seguenti user agent:

- Immagine google

- Google Mobile

- Ricerca MSN

- Yahoo

- YahooMM

- Blog di Yahoo

- Baidu

- MSN PicSearch

Puoi selezionare diversi agenti utente per diversi URL.

PASSO 3: Consenti/Non consenti robot dei motori di ricerca

Seleziona "Consenti o Non consenti" per impostare le meta direttive robots per gli URL specificati.

È possibile impostare separatamente la direttiva "Consenti" o "Disallow" per ciascun URL.

Perché utilizzare il generatore Robots.txt di ETTVI?

Robots.txt è un file utilizzato per fornire istruzioni al crawler del motore di ricerca su quali URL possono essere sottoposti a scansione o indicizzati e quali no. Il file robots.txt è molto importante e vantaggioso per i webmaster e ogni esperto SEO utilizza robots.txt per scopi diversi.

Tuttavia, se non scritto correttamente, può causare problemi di indicizzazione nel tuo sito e Google non sarà in grado di eseguire correttamente la scansione del tuo sito web. Utilizzando il generatore Robots.txt di ETTVI, puoi generare un file accurato anziché codificarlo manualmente con un solo clic.

Crea rapidamente il file Robots.txt

Robots.txt Generator può salvarti da qualsiasi errore di codifica e farti risparmiare molto tempo che puoi applicare ad altre attività SEO come la generazione della mappa del sito. La maggior parte degli esperti SEO consiglia Robots.txt Generator di ETTVI perché è uno strumento efficiente, veloce e gratuito che creerà il tuo robots.txt in pochissimo tempo in base alle tue esigenze.

Nascondi pagine private

Supponiamo che tu abbia una pagina privata e che desideri mostrarla solo alle persone iscritte, ma se viene indicizzata tutti possono vederla. Quindi, per evitare questo problema devi non consentire le tue pagine private in robots.txt.

Salva budget di scansione

Se hai molte pagine extra (come i tag), queste possono disturbare il tuo budget di scansione e causare problemi di indicizzazione. Pertanto, non consentiamo pagine aggiuntive nel file robots.txt per evitare questo problema.

Capire Robots.txt?

Il file Robots.txt è un file di testo che contiene informazioni su come un crawler dovrebbe eseguire la scansione di un sito web. Inoltre, puoi specificare a quali aree non desideri consentire l'accesso ai crawler, ad esempio aree con contenuti duplicati o quelle in costruzione. Esistono alcuni bot che non seguono questo standard, inclusi rilevatori di malware e raccoglitori di e-mail. Di conseguenza, cercheranno i punti deboli del tuo sistema di sicurezza. Se non desideri che determinate aree vengano indicizzate, c'è una ragionevole possibilità che inizino a rivedere il tuo sito web da quelle aree.

Solitamente ci sono due file Robots.txt: uno fornisce lo "User-agent" e l'altro include le direttive "Consenti", "Disallow", "Crawl-Delay" ecc. La scrittura manuale di un file di righe di comando potrebbe richiedere molto tempo molto tempo e il file può contenere più righe di comandi contemporaneamente. Dovresti scrivere "Disallow: il collegamento che non desideri venga visitato dai bot" nella pagina successiva. Lo stesso metodo si applica al comando "consentendo".

Perché Robots.txt è importante?

I file Robots.txt non sono richiesti dalla maggior parte dei siti Web. Di conseguenza, Google è spesso in grado di trovare tutte le pagine importanti del tuo sito web e di indicizzarle senza alcuna difficoltà. E non indicizzeranno le pagine che non sono importanti o i duplicati di pagine già indicizzate.

Tuttavia, esistono tre ragioni principali per utilizzare un file robots.txt.

Non consentire la visualizzazione delle pagine non pubbliche. A volte, non desideri che determinate pagine vengano indicizzate sul tuo sito. Potresti, ad esempio, avere versioni di staging di determinate pagine o una pagina di accesso. È fondamentale che queste pagine esistano e che gli utenti non vengano indirizzati ad esse. Pertanto, il file robots.txt dovrebbe essere utilizzato per impedire a crawler e bot di accedere a queste pagine.

Ottieni il massimo dal tuo budget di scansione. Potrebbe esserci un problema di crawl budget se hai difficoltà a indicizzare le tue pagine. Quando utilizzi robots.txt per bloccare pagine non importanti, Googlebot trascorrerà più tempo sulle pagine web che sono effettivamente importanti.

Le risorse non devono essere indicizzate. Puoi utilizzare le meta direttive per impedire che una pagina venga indicizzata con la stessa efficienza dell'utilizzo di un file Robot.txt. Le meta direttive, tuttavia, non funzionano bene con risorse multimediali come PDF e immagini. In questo caso, robots.txt sarebbe utile.

Quando i bot dei motori di ricerca esaminano i file, cercano innanzitutto il file robots.txt e, se questo file non viene trovato, c'è una significativa possibilità che tutte le pagine del tuo sito non vengano indicizzate. Quando aggiungi più pagine, puoi modificare il file Robot.txt con alcune istruzioni aggiungendo la pagina principale all'elenco delle pagine non consentite. Tuttavia, evita di aggiungere la pagina principale all'elenco dei contenuti non consentiti all'inizio del file.

Esiste un budget per la scansione del sito Web di Google; questo budget è determinato da un limite di scansione. Di norma, i crawler trascorrono un certo periodo di tempo su un sito web prima di passare a quello successivo, ma se Google scopre che la scansione del tuo sito disturba i tuoi utenti, eseguirà la scansione del tuo sito più lentamente. A causa dello spidering più lento del tuo sito web da parte di Google, indicizzerà solo poche pagine del tuo sito alla volta, quindi il tuo post più recente richiederà tempo per essere indicizzato completamente. È necessario che il tuo sito abbia una mappa del sito e un file robots.txt per risolvere questo problema. Il processo di scansione verrà reso più rapido indirizzandoli verso i link del tuo sito che richiedono particolare attenzione in modo da velocizzare il processo di scansione.

Oltre ad avere una velocità di scansione per un sito Web, ogni bot ha la propria quota di scansione unica. Ecco perché hai bisogno di un file robot per il tuo sito Web WordPress. Ciò è dovuto al fatto che è composto da molte pagine che non sono necessarie per l'indicizzazione. Inoltre, se scegli di non includere un file robots.txt, i crawler indicizzeranno comunque il tuo sito web, ma a meno che non sia un blog molto grande e contenga molte pagine, non è necessario.

Lo scopo delle direttive in un file Robot.txt:

Quando si crea il file manuale, è fondamentale essere consapevoli di come deve essere formattato il file. Inoltre, dopo aver appreso come funziona, puoi modificarlo.

Ritardo del tempo di scansione: impostando questa direttiva, i crawler non sovraccaricheranno il server, poiché troppe richieste sovraccaricheranno il server, non garantendo un'esperienza utente ottimale. Diversi bot dei motori di ricerca rispondono in modo diverso alla direttiva Crawl-Delay. Ad esempio, Bing, Google e Yandex rispondono tutti in modo diverso.

Consentire: utilizzando questa direttiva, consentiamo l'indicizzazione dei seguenti URL. Indipendentemente dal numero di URL che puoi aggiungere al tuo elenco, se gestisci un sito di e-commerce, potresti avere molti URL da aggiungere. Se decidi di utilizzare il file robots, dovresti usarlo solo per le pagine che non desideri vengano indicizzate.

Disallowing: tra le funzioni più importanti di un file Robots c'è quella di impedire ai crawler di accedere a collegamenti, directory, ecc. al suo interno. Tuttavia, altri bot possono accedere a queste directory, il che significa che devono verificare la presenza di malware perché non sono conformi.

Differenza tra una Sitemap e un file Robot.txt

Una mappa del sito contiene informazioni preziose per i motori di ricerca ed è essenziale per tutti i siti web. Le mappe del sito informano i bot quando il tuo sito web viene aggiornato e che tipo di contenuti offre il tuo sito web. Lo scopo della pagina è informare il motore di ricerca di tutte le pagine contenute nel tuo sito che devono essere scansionate, mentre lo scopo del file robots.txt è di avvisare il crawler. Ai crawler viene detto quali pagine scansionare e quali evitare utilizzando Robot.txt. Affinché il tuo sito web venga indicizzato, avrai bisogno di una mappa del sito, mentre robot.txt non è richiesto.

Domande frequenti

Cos'è il file Robots.txt?

Cos'è il generatore Robots.txt?

Robots.txt Generator è uno strumento online basato sul web che consente ai webmaster di creare robots.txt personalizzati in base alle loro esigenze senza alcuna codifica manuale.

Robots.txt è necessario?

No, non è necessario un robots.txt ma con esso puoi avere il controllo sui crawler dei motori di ricerca. La maggior parte degli esperti consiglia di avere un file robots.txt sul tuo sito web.

Come faccio a creare un file Robots.txt?

Puoi crearne uno con la codifica manuale ma è troppo pericoloso e può causare problemi di indicizzazione. Quindi, la soluzione migliore per evitare questo problema è utilizzare un generatore Robots.txt come quello di Ettvi. Il generatore Robots.txt di Ettvi ti consente di creare gratuitamente il tuo file personalizzato.

Come verificare se My Robots.txt è buono o no?

Dopo aver generato e posizionato Robots.txt, la domanda principale è: come convalidare il file robots.txt? Puoi convalidare facilmente il tuo file con lo strumento di convalida Robots.txt di ETTVI.

Rimani aggiornato nel mondo della posta elettronica.

Iscriviti per ricevere e-mail settimanali con articoli, guide e video curati per migliorare le tue tattiche.