Robots.txt é um arquivo colocado no diretório raiz - é usado para fornecer instruções ao rastreador do mecanismo de pesquisa sobre como rastrear e indexar o site . Pode ser benéfico ou perigoso dependendo da maneira como você o utiliza.

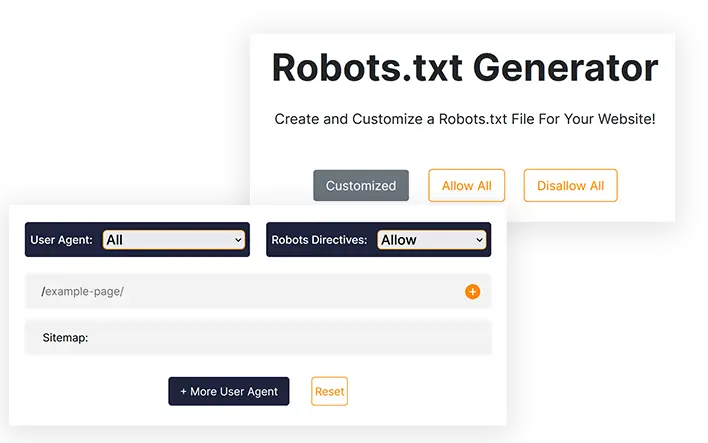

Gerador Robots.txt

Crie e personalize um arquivo Robots.txt para o seu site!

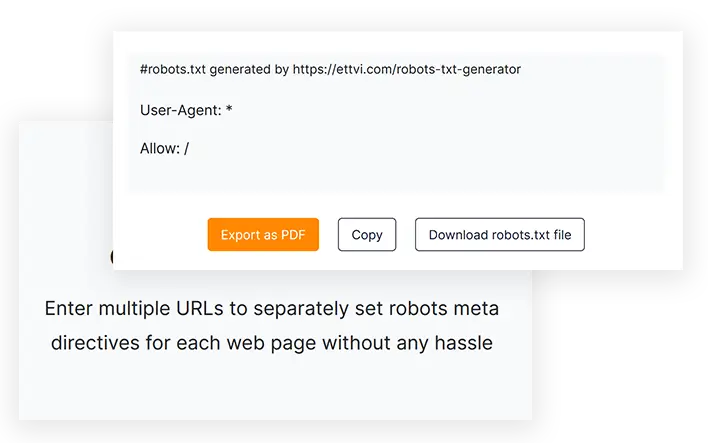

#robots.txt gerado por https://ettvi.com/robots-txt-generator

User-Agent: *

Allow: /

| Customized |

|---|

| Allow |

|---|

| Disallow |

|---|

Características

Gerar arquivo Robots.txt

Crie um arquivo robots.txt para seu site ou páginas da web para especificar instruções de rastreamento sem nenhum erro de codificação

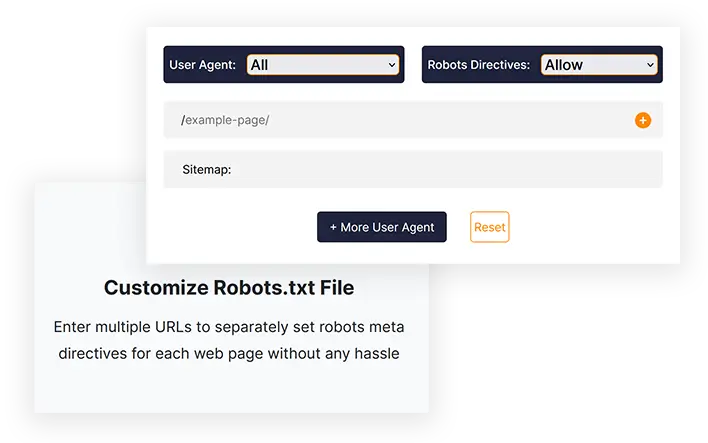

Personalizar arquivo Robots.txt

Insira vários URLs para definir metadiretivas de robôs separadamente para cada página da web sem complicações

Exportar com um clique

Copie o código robots.txt ou baixe diretamente o arquivo robots.txt para fazer upload no diretório raiz do seu site

Ferramentas Relacionadas

Gerador Robots.txt da ETTVI

Crie um arquivo Robots.txt para o seu site para determinar o comportamento dos rastreadores de mecanismos de pesquisa com o Gerador Robots.txt da ETTVI. Os webmasters podem aproveitar esta ferramenta para gerar um arquivo Robots.txt padrão com configurações padrão ou personalizá-lo para definir instruções de rastreamento específicas para diferentes páginas da web.

Aproveite as vantagens das funcionalidades de nível avançado do Gerador Robots.txt da ETTVI para restringir o rastreamento de um diretório ou ocultar suas páginas privadas do rastreador.

Inclua separadamente metadiretivas de robôs para cada URL para indicar o que e como os rastreadores podem acessar os respectivos links sem desperdiçar seu orçamento de rastreamento. Permita ou proíba que diferentes rastreadores de mecanismos de pesquisa rastreiem seu conteúdo da web conforme necessário.

O Robots.txt Creator da ETTVI processa efetivamente as informações fornecidas para especificar as instruções de rastreamento sem qualquer erro de codificação. Informe os rastreadores sobre como eles devem rastrear e indexar suas páginas da web com o Gerador Robots.txt da ETTVI gratuitamente.

Como usar o gerador Robots.txt da ETTVI?

O Gerador Robots.txt da ETTVI permite que os usuários gerem um arquivo Robots.txt padrão com instruções de rastreamento “Todos Permitirem” ou “Todos Não Permitirem”, bem como criar um arquivo Robots.txt personalizado com funcionalidades adicionais.

Gere um arquivo Robots.txt padrão

Siga estas etapas para gerar um arquivo Robots.txt padrão com configurações padrão:

PASSO 1 - Definir metadiretivas para robôs

Você pode definir diretivas de permissão/proibição para “todos os robôs de mecanismos de pesquisa” para gerar um arquivo robots.txt padrão. Escolha “Permitir” ou “Não permitir” para aplicar as configurações padrão:

PASSO 2 - Insira o endereço do mapa do site

Insira o link para o mapa do site do seu site ou deixe-o em branco se não tiver nenhum.

Você pode inserir mais de um sitemap específico de categoria das páginas, postagens, categorias e tags do seu site.

PASSO 3 - Obtenha o código Robots.txt

Assim que você insere as informações necessárias, o Gerador Robots.txt da ETTVI gera e exibe automaticamente o código Robots.txt.

Você pode baixar ou copiar o código para enviar o arquivo Robots.txt para o diretório raiz do seu site.

Gerar arquivo Robots.txt personalizado

Siga estas etapas para gerar um arquivo Robots.txt padrão com configurações padrão:

Insira os URLs:

PASSO 2 - Selecione o Agente do Usuário

Você pode definir diretivas de meta-robôs para qualquer um dos seguintes agentes de usuário:

- imagem do Google

- Google Celular

- Pesquisa do MSN

- Yahoo

- Yahoo MM

- Blogs do Yahoo

- Baidu

- MSN PicSearch

Você pode selecionar diferentes agentes de usuário para diferentes URLs.

ETAPA 3 - Permitir/Proibir robôs de mecanismos de pesquisa

Selecione “Permitir ou Proibir” para definir as metadiretivas de robôs para os URLs fornecidos.

Você pode definir separadamente a diretiva “Permitir” ou “Proibir” para cada URL.

Por que usar o gerador Robots.txt da ETTVI?

Robots.txt é um arquivo usado para fornecer instruções ao rastreador do mecanismo de pesquisa sobre quais URLs podem ser rastreados ou indexados ou quais não deveriam. O robots.txt é muito importante e benéfico para webmasters e todo especialista em SEO usa o robots.txt para diferentes propósitos.

No entanto, se não for escrito corretamente, pode causar problemas de indexação em seu site e o Google não conseguir rastreá-lo corretamente. Usando o Gerador Robots.txt da ETTVI, você pode gerar um arquivo preciso em vez de codificar manualmente com apenas um clique.

Crie rapidamente um arquivo Robots.txt

O Gerador Robots.txt pode salvá-lo de qualquer erro de codificação e economiza muito tempo que você pode aplicar em outras tarefas de SEO, como Gerar Sitemap. A maioria dos especialistas em SEO recomenda o Gerador Robots.txt da ETTVI porque é uma ferramenta eficiente, rápida e gratuita que fará seu robots.txt rapidamente de acordo com suas necessidades.

Ocultar páginas privadas

Suponha que você tenha uma página privada e queira mostrá-la apenas para pessoas inscritas, mas se ela for indexada, todos poderão vê-la. Portanto, para evitar esse problema, você precisa proibir suas páginas privadas no robots.txt.

Salvar orçamento de rastreamento

Se você tiver muitas páginas extras (como tags), elas podem atrapalhar seu orçamento de rastreamento e causar problemas de indexação. Portanto, não permitimos páginas extras no robots.txt para evitar esse problema.

Compreendendo o Robots.txt?

O arquivo Robots.txt é um arquivo de texto que contém informações sobre como um rastreador deve rastrear um site. Além disso, você pode especificar quais áreas não deseja permitir o acesso dos crawlers, por exemplo, áreas com conteúdo duplicado ou em construção. Existem alguns bots que não seguem esse padrão, incluindo detectores de malware e coletores de e-mail. Como resultado, eles procurarão pontos fracos no seu sistema de segurança. Se você não deseja que determinadas áreas sejam indexadas, há uma chance razoável de que eles comecem a revisar seu site a partir dessas áreas.

Normalmente existem dois arquivos Robots.txt: um fornece o "User-agent" e o outro inclui diretivas que são 'Allow', 'Disallow', 'Crawl-Delay' etc. muito tempo e o arquivo pode conter várias linhas de comandos ao mesmo tempo. Você deve escrever "Não permitir: o link que você não deseja que os bots visitem" na página seguinte. O mesmo método se aplica ao comando "permitir".

Por que o Robots.txt é importante?

Os arquivos Robots.txt não são exigidos pela maioria dos sites. Como resultado, o Google muitas vezes consegue encontrar todas as páginas importantes do seu site e indexá-las sem qualquer dificuldade. E não indexarão páginas que não sejam importantes ou duplicatas de páginas já indexadas.

No entanto, existem três razões principais para usar um arquivo robots.txt.

Não permita que páginas não públicas sejam vistas. Às vezes, você não deseja que determinadas páginas sejam indexadas em seu site. Você pode, por exemplo, ter versões temporárias de determinadas páginas ou uma página de login. É imperativo que essas páginas existam e que usuários aleatórios não sejam direcionados a elas. Portanto, o robots.txt deve ser usado para bloquear o acesso de rastreadores e bots a essas páginas.

Aproveite ao máximo seu orçamento de rastreamento. Pode haver um problema de orçamento de rastreamento se você estiver tendo dificuldades para indexar suas páginas. Quando você usa o robots.txt para bloquear páginas sem importância, o Googlebot passa mais tempo nas páginas da web que são realmente importantes.

Os recursos não devem ser indexados. Você pode usar metadiretivas para evitar que uma página seja indexada com a mesma eficiência que usar um arquivo Robot.txt. As metadiretivas, entretanto, não funcionam bem com recursos multimídia como PDFs e imagens. Neste caso, robots.txt seria útil.

Quando os bots dos mecanismos de pesquisa examinam os arquivos, eles procuram primeiro o arquivo robots.txt e, se esse arquivo não for encontrado, há uma chance significativa de que todas as páginas do seu site não sejam indexadas. Ao adicionar mais páginas, você pode modificar o arquivo Robot.txt com algumas instruções, adicionando a página principal à lista de proibições. No entanto, evite adicionar a página principal à lista de proibições no início do arquivo.

Existe um orçamento para rastrear o site do Google; esse orçamento é determinado por um limite de rastreamento. Como regra, os rastreadores passarão um certo tempo em um site antes de passar para o próximo, mas se o Google descobrir que o rastreamento do seu site está incomodando os usuários, ele o rastreará mais lentamente. Devido ao rastreamento mais lento do seu site pelo Google, ele indexará apenas algumas páginas do seu site por vez, portanto, sua postagem mais recente levará algum tempo para ser totalmente indexada. É necessário que seu site tenha um mapa do site e um arquivo robots.txt para corrigir esse problema. O processo de rastreamento será agilizado direcionando-os para os links do seu site que requerem atenção especial para agilizar o processo de rastreamento.

Além de ter uma taxa de rastreamento para um site, cada bot tem sua própria cotação de rastreamento exclusiva. É por isso que você precisa de um arquivo robô para o seu site WordPress. Isso se deve ao fato de ser composto por uma grande quantidade de páginas que não são necessárias para indexação. Além disso, se você optar por não incluir um arquivo robots.txt, os rastreadores ainda indexarão seu site, mas a menos que seja um blog muito grande e contenha muitas páginas, isso não é necessário.

O objetivo das diretivas em um arquivo Robot.txt:

Ao criar o arquivo manual, é fundamental que você esteja ciente de como o arquivo deve ser formatado. Além disso, depois de aprender como funciona, você pode modificá-lo.

Atraso no tempo de rastreamento: Ao definir esta diretiva, os rastreadores não sobrecarregarão o servidor, pois muitas solicitações sobrecarregarão o servidor, não resultando em uma experiência de usuário ideal. Diferentes bots de mecanismos de pesquisa respondem de maneira diferente à diretiva Crawl-Delay. Por exemplo, Bing, Google e Yandex respondem de maneira diferente.

Permitir: Ao usar esta diretiva, permitimos que os seguintes URLs sejam indexados. Independentemente do número de URLs que você pode adicionar à sua lista, se você estiver administrando um site de comércio eletrônico, poderá ter muitos URLs para adicionar. Se você decidir usar o arquivo robots, deverá usá-lo apenas para as páginas que não deseja que sejam indexadas.

Proibição: uma das funções mais importantes de um arquivo Robots é impedir que rastreadores acessem links, diretórios, etc. No entanto, outros bots podem acessar esses diretórios, o que significa que precisam verificar se há malware porque não são compatíveis.

Diferença entre um Sitemap e um arquivo Robot.txt

Um mapa do site contém informações valiosas para os mecanismos de pesquisa e é essencial para todos os sites. Os Sitemaps informam aos bots quando o seu site é atualizado e também que tipo de conteúdo ele oferece. O objetivo da página é informar ao mecanismo de pesquisa todas as páginas que seu site contém que devem ser rastreadas, enquanto o objetivo do arquivo robots.txt é notificar o rastreador. Os rastreadores são informados sobre quais páginas rastrear e quais evitar usando Robot.txt. Para que o seu site seja indexado, você precisará de um mapa do site, enquanto o robot.txt não é obrigatório.

Perguntas Frequentes

O que é o arquivo Robots.txt?

O que é o gerador Robots.txt?

Robots.txt Generator é uma ferramenta online baseada na web que permite aos webmasters criar robots.txt personalizados de acordo com suas necessidades, sem qualquer codificação manual.

O Robots.txt é necessário?

Não, um robots.txt não é necessário, mas com ele você pode ter controle sobre os rastreadores dos motores de busca. A maioria dos especialistas recomenda ter um arquivo robots.txt em seu site.

Como faço para criar um arquivo Robots.txt?

Você pode criar um com codificação manual, mas é muito perigoso e pode causar problemas de indexação. Portanto, a melhor solução para evitar esse problema é usar um Gerador Robots.txt como o do Ettvi. O Gerador Robots.txt da Ettvi permite que você crie seu próprio arquivo personalizado gratuitamente.

Como validar se meu Robots.txt é bom ou não?

Depois de gerar e colocar o Robots.txt, surge uma grande questão: como validar o arquivo robots.txt? Você pode validar facilmente seu arquivo com a ferramenta de validação Robots.txt da ETTVI.

Mantenha-se atualizado no mundo do e-mail.

Assine e-mails semanais com artigos, guias e vídeos selecionados para aprimorar suas táticas.