Robots.txt est un fichier placé dans le répertoire racine. Il est utilisé pour donner des instructions au robot d'exploration du moteur de recherche concernant l'exploration et l'indexation du site . Cela peut être bénéfique ou dangereux selon la façon dont vous l’utilisez.

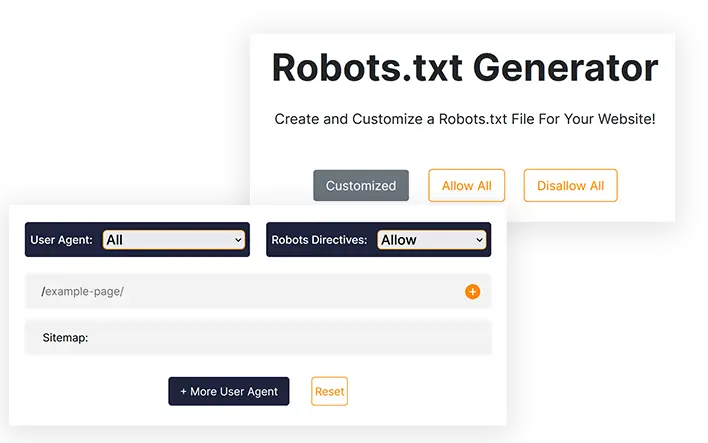

Générateur de robots.txt

Créez et personnalisez un fichier Robots.txt pour votre site Web !

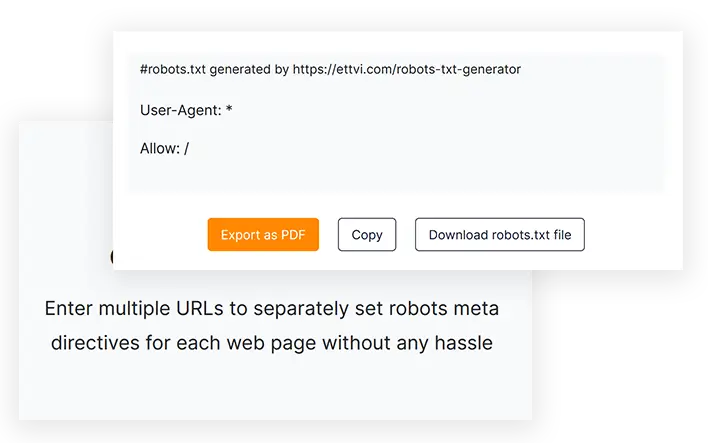

#robots.txt généré par https://ettvi.com/robots-txt-generator

User-Agent: *

Allow: /

| Customized |

|---|

| Allow |

|---|

| Disallow |

|---|

Caractéristiques

Générer un fichier Robots.txt

Créez un fichier robots.txt pour votre site Web ou vos pages Web afin de spécifier les instructions d'exploration sans aucune erreur de codage

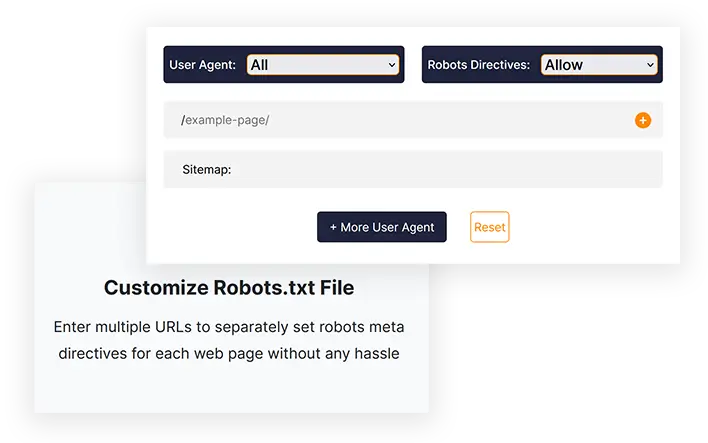

Personnaliser le fichier Robots.txt

Entrez plusieurs URL pour définir séparément les méta-directives des robots pour chaque page Web sans aucun problème

Exporter en un clic

Copiez le code robots.txt ou téléchargez directement le fichier robots.txt à télécharger dans le répertoire racine de votre site Web

Outils associés

Générateur Robots.txt d'ETTVI

Créez un fichier Robots.txt pour votre site Web afin de déterminer le comportement des robots des moteurs de recherche avec le générateur Robots.txt d'ETTVI. Les webmasters peuvent exploiter cet outil pour générer un fichier Robots.txt standard avec les paramètres par défaut ou le personnaliser pour définir des instructions d'exploration spécifiques pour différentes pages Web.

Profitez des fonctionnalités de niveau avancé du générateur Robots.txt d'ETTVI pour empêcher l'exploration d'un répertoire ou masquer vos pages privées au robot d'exploration.

Incluez séparément les méta-directives des robots pour chaque URL afin d'indiquer quoi et comment les robots d'exploration peuvent accéder aux liens respectifs sans gaspiller votre budget d'exploration. Autorisez ou interdisez à différents robots d'exploration des moteurs de recherche d'explorer votre contenu Web selon les besoins.

Le créateur Robots.txt d'ETTVI traite efficacement les informations fournies pour spécifier les instructions d'exploration sans aucune erreur de codage. Informez gratuitement les robots d'exploration de la manière dont ils doivent explorer et indexer vos pages Web avec le générateur Robots.txt d'ETTVI.

Comment utiliser le générateur Robots.txt d'ETTVI ?

Le générateur Robots.txt d'ETTVI permet aux utilisateurs de générer un fichier Robots.txt par défaut avec les instructions d'exploration « All Allow » ou « All Disallow » ainsi que de créer un fichier Robots.txt personnalisé avec des fonctionnalités supplémentaires.

Générer un fichier Robots.txt standard

Suivez ces étapes pour générer un fichier Robots.txt standard avec les paramètres par défaut :

ÉTAPE 1 - Définir les méta-directives des robots

Vous pouvez définir des directives d'autorisation/interdiction pour « tous les robots des moteurs de recherche » afin de générer un fichier robots.txt standard. Choisissez « Autoriser » ou « Interdire » pour appliquer les paramètres par défaut :

ÉTAPE 2 - Entrez l'adresse du plan du site

Entrez le lien vers le plan du site de votre site Web ou laissez-le vide si vous n'en avez pas.

Vous pouvez saisir plusieurs plans de site spécifiques à une catégorie des pages, publications, catégories et balises de votre site Web.

ÉTAPE 3 - Obtenez le code Robots.txt

Juste au moment où vous saisissez les informations requises, le générateur Robots.txt d'ETTVI génère et affiche automatiquement le code Robots.txt.

Vous pouvez télécharger ou copier le code pour soumettre le fichier Robots.txt dans le répertoire racine de votre site Web.

Générer un fichier Robots.txt personnalisé

Suivez ces étapes pour générer un fichier Robots.txt standard avec les paramètres par défaut :

Saisissez les URL :

ÉTAPE 2 - Sélectionnez l'agent utilisateur

Vous pouvez définir des directives de méta-robots pour l'un des agents utilisateurs suivants :

- Google Image

- Google Mobile

- Recherche MSN

- Yahoo

- YahooMM

- Blogs Yahoo

- Baidu

- MSN PicSearch

Vous pouvez sélectionner différents agents utilisateurs pour différentes URL.

ÉTAPE 3 – Autoriser/interdire les robots des moteurs de recherche

Sélectionnez « Autoriser ou Interdire » pour définir les méta-directives des robots pour les URL données.

Vous pouvez définir séparément la directive « Autoriser » ou « Interdire » pour chaque URL.

Pourquoi utiliser le générateur Robots.txt d'ETTVI ?

Robots.txt est un fichier utilisé pour donner des instructions au robot d'exploration du moteur de recherche sur les URL qui peuvent être explorées ou indexées ou qui ne doivent pas l'être. Le fichier robots.txt est très crucial et bénéfique pour les webmasters et chaque expert SEO utilise le fichier robots.txt à des fins différentes.

Cependant, s'il n'est pas rédigé correctement, cela peut entraîner des problèmes d'indexation sur votre site et Google ne pourra pas explorer correctement votre site Web. En utilisant le générateur Robots.txt d'ETTVI, vous pouvez générer un fichier précis plutôt que de le coder manuellement en un seul clic.

Créez rapidement un fichier Robots.txt

Le générateur Robots.txt peut vous éviter toute erreur de codage et vous fait gagner beaucoup de temps que vous pouvez appliquer à d'autres tâches de référencement telles que la génération d'un plan du site. La plupart des experts SEO recommandent le Générateur Robots.txt d'ETTVI car c'est un outil efficace, rapide et gratuit qui réalisera votre robots.txt en un rien de temps selon vos besoins.

Masquer les pages privées

Supposons que si vous avez une page privée que vous souhaitez uniquement montrer aux personnes abonnés, mais si elle est indexée, tout le monde peut la voir - Donc, pour éviter ce problème, vous devez interdire vos pages privées dans robots.txt.

Économiser le budget d'exploration

Si vous avez beaucoup de pages supplémentaires (Like Tags), elles peuvent perturber votre budget d'exploration et provoquer des problèmes d'indexation. Nous interdisons donc les pages supplémentaires dans robots.txt pour éviter ce problème.

Vous comprenez Robots.txt ?

Le fichier Robots.txt est un fichier texte qui contient des informations sur la manière dont un robot doit explorer un site Web. De plus, vous pouvez spécifier les zones auxquelles vous ne souhaitez pas autoriser les robots d'exploration à accéder, par exemple les zones avec du contenu en double ou celles en construction. Certains robots ne respectent pas cette norme, notamment les détecteurs de logiciels malveillants et les collecteurs d'e-mails. En conséquence, ils rechercheront les points faibles de votre système de sécurité. Si vous ne souhaitez pas que certaines zones soient indexées, il y a de fortes chances qu'ils commencent à examiner votre site Web à partir de ces zones.

Il existe généralement deux fichiers Robots.txt : l'un fournit "l'agent utilisateur" et l'autre inclut les directives "Autoriser", "Disallow", "Crawl-Delay", etc. L'écriture manuelle d'un fichier de lignes de commande peut prendre beaucoup de temps. longtemps et le fichier peut contenir plusieurs lignes de commandes à la fois. Vous devez écrire « Interdire : le lien que vous ne souhaitez pas que les robots visitent » sur la page suivante. La même méthode s'applique pour la commande "autoriser".

Pourquoi le fichier Robots.txt est-il important ?

Les fichiers Robots.txt ne sont pas requis par la plupart des sites Web. De ce fait, Google est souvent capable de retrouver toutes les pages importantes de votre site internet, et de les indexer, sans aucune difficulté. Et ils n’indexeront pas les pages sans importance ni les doublons de pages déjà indexées.

Cependant, il existe trois raisons principales d’utiliser un fichier robots.txt.

Ne permettez pas que les pages non publiques soient vues. Parfois, vous ne souhaitez pas que certaines pages soient indexées sur votre site. Vous pouvez, par exemple, disposer de versions intermédiaires de certaines pages ou d'une page de connexion. Il est impératif que ces pages existent et les utilisateurs d'andom ne doivent pas y être dirigés. Ainsi, le fichier robots.txt doit être utilisé pour empêcher les robots d'exploration et les robots d'accéder à ces pages.

Tirez le meilleur parti de votre budget de crawl. Il peut y avoir un problème de budget d'exploration si vous rencontrez des difficultés pour indexer vos pages. Lorsque vous utilisez robots.txt pour bloquer des pages sans importance, Googlebot passera plus de temps sur les pages Web réellement importantes.

Les ressources ne doivent pas être indexées. Vous pouvez utiliser des méta-directives pour empêcher une page d'être indexée aussi efficacement que l'utilisation d'un fichier Robot.txt. Toutefois, les méta-directives ne fonctionnent pas bien avec les ressources multimédias telles que les PDF et les images. Dans ce cas, robots.txt serait utile.

Lorsque les robots des moteurs de recherche examinent des fichiers, ils recherchent d'abord le fichier robots.txt, et si ce fichier n'est pas trouvé, il y a de fortes chances que toutes les pages de votre site ne soient pas indexées. Lorsque vous ajoutez plus de pages, vous pouvez modifier le fichier Robot.txt avec quelques instructions en ajoutant la page principale à la liste d'interdiction. Cependant, évitez d'ajouter la page principale à la liste d'interdiction au début du fichier.

Il existe un budget pour explorer le site Web de Google ; ce budget est déterminé par une limite d'exploration. En règle générale, les robots passent un certain temps sur un site Web avant de passer au suivant, mais si Google découvre que l'exploration de votre site dérange vos utilisateurs, il explorera votre site plus lentement. En raison de l'exploration plus lente de votre site Web par Google, celui-ci n'indexera que quelques pages de votre site à la fois, de sorte que votre publication la plus récente prendra du temps à être entièrement indexée. Il est nécessaire que votre site dispose d'un plan du site et d'un fichier robots.txt afin de résoudre ce problème. Le processus d'exploration sera accéléré en les dirigeant vers les liens de votre site qui nécessitent une attention particulière afin d'accélérer le processus d'exploration.

En plus d'avoir un taux d'exploration pour un site Web, chaque bot possède son propre devis d'exploration unique. C'est pourquoi vous avez besoin d'un fichier robot pour votre site Web WordPress. Cela est dû au fait qu’il se compose d’un grand nombre de pages qui ne sont pas nécessaires à l’indexation. De plus, si vous choisissez de ne pas inclure de fichier robots.txt, les robots indexeront quand même votre site Web, mais à moins qu'il ne s'agisse d'un très gros blog et qu'il contienne de nombreuses pages, ce n'est pas nécessaire.

Le but des directives dans un fichier Robot.txt :

Lors de la création du fichier manuel, il est impératif que vous sachiez comment le fichier doit être formaté. De plus, après avoir appris son fonctionnement, vous pouvez le modifier.

Délai d'exploration : en définissant cette directive, les robots d'exploration ne surchargeront pas le serveur, car trop de requêtes rendront le serveur surchargé, ce qui n'entraînera pas une expérience utilisateur optimale. Différents robots des moteurs de recherche réagissent différemment à la directive Crawl-Delay. Par exemple, Bing, Google et Yandex réagissent tous différemment.

Autoriser : en utilisant cette directive, nous autorisons l'indexation des URL suivantes. Quel que soit le nombre d'URL que vous pouvez ajouter à votre liste, si vous exploitez un site Web de commerce électronique, vous devrez peut-être ajouter de nombreuses URL. Si vous décidez d'utiliser le fichier robots, vous ne devez l'utiliser que pour les pages que vous ne souhaitez pas indexer.

Interdiction : l'une des fonctions les plus importantes d'un fichier Robots est d'empêcher les robots d'exploration de pouvoir accéder aux liens, répertoires, etc. qu'il contient. Cependant, d'autres robots peuvent accéder à ces répertoires, ce qui signifie qu'ils doivent rechercher les logiciels malveillants car ils ne sont pas conformes.

Différence entre un plan du site et un fichier Robot.txt

Un plan du site contient des informations précieuses pour les moteurs de recherche et est essentiel pour tous les sites Web. Les plans de site informent les robots lorsque votre site Web est mis à jour ainsi que du type de contenu proposé par votre site Web. Le but de la page est d'informer le moteur de recherche de toutes les pages contenues dans votre site qui doivent être explorées, tandis que le but du fichier robots.txt est d'informer le robot d'exploration. Les robots d'exploration sont informés des pages à explorer et de celles à éviter d'utiliser Robot.txt. Pour que votre site Web soit indexé, vous aurez besoin d'un plan du site, alors que robot.txt n'est pas requis.

Foire aux questions

Qu'est-ce que le fichier Robots.txt ?

Qu'est-ce que le générateur Robots.txt ?

Robots.txt Generator est un outil Web en ligne qui permet aux webmasters de créer des robots.txt personnalisés en fonction de leurs besoins sans aucun codage manuel.

Le fichier Robots.txt est-il nécessaire ?

Non, un fichier robots.txt n'est pas nécessaire, mais il vous permet de contrôler les robots des moteurs de recherche. La plupart des experts recommandent d'avoir un fichier robots.txt sur votre site Web.

Comment créer un fichier Robots.txt ?

Vous pouvez en créer un avec un codage manuel mais c'est trop dangereux et peut provoquer des problèmes d'indexation. Ainsi, la meilleure solution pour éviter ce problème est d'utiliser un générateur Robots.txt comme celui d'Ettvi. Le générateur Robots.txt d'Ettvi vous permet de créer gratuitement votre propre fichier personnalisé.

Comment valider si mon Robots.txt est bon ou non ?

Après avoir généré et placé Robots.txt, la question majeure se pose de savoir comment valider le fichier robots.txt ? Vous pouvez facilement valider votre fichier avec l'outil de validation Robots.txt d'ETTVI.

Restez à jour dans le monde du courrier électronique.

Abonnez-vous pour recevoir des e-mails hebdomadaires avec des articles, des guides et des vidéos sélectionnés pour améliorer vos tactiques.