Robots.txt es un archivo que se coloca en el directorio raíz y se utiliza para dar instrucciones al rastreador del motor de búsqueda sobre cómo rastrear e indexar el sitio . Puede ser beneficioso o peligroso dependiendo de su forma de usarlo.

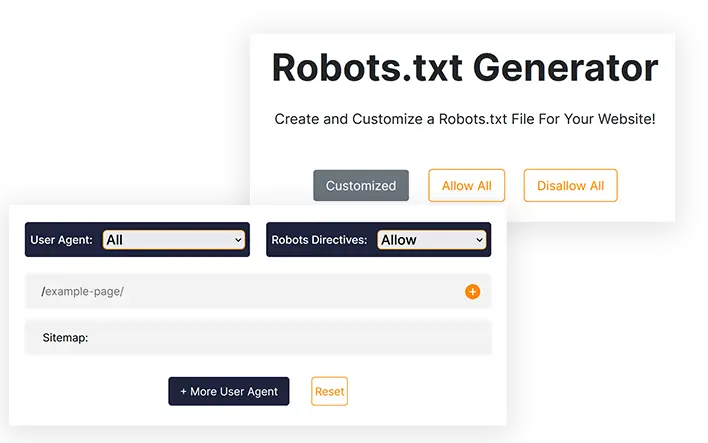

Generador de robots.txt

¡Cree y personalice un archivo Robots.txt para su sitio web!

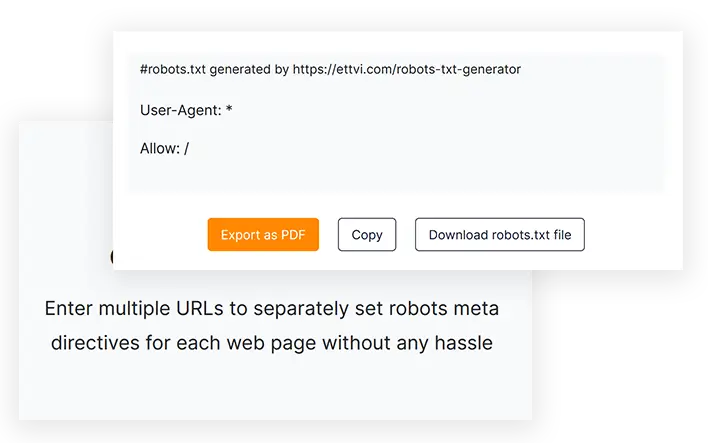

#robots.txt generado por https://ettvi.com/robots-txt-generator

User-Agent: *

Allow: /

| Customized |

|---|

| Allow |

|---|

| Disallow |

|---|

Características

Generar archivo Robots.txt

Cree un archivo robots.txt para su sitio web o páginas web para especificar instrucciones de rastreo sin ningún error de codificación.

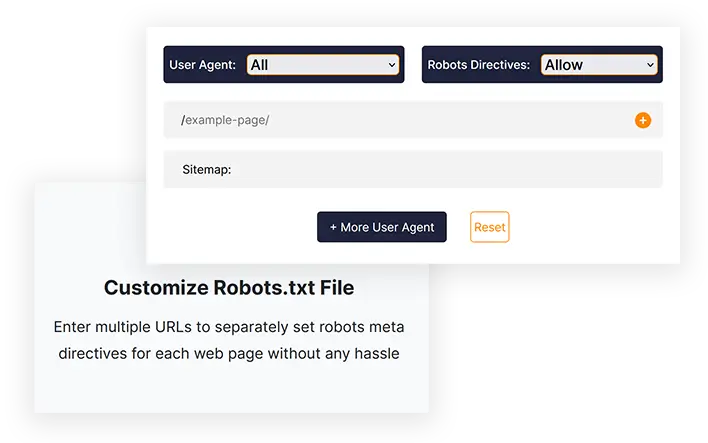

Personalizar el archivo Robots.txt

Ingrese varias URL para configurar metadirectivas de robots por separado para cada página web sin ningún problema

Exportar con un clic

Copie el código robots.txt o descargue directamente el archivo robots.txt para cargarlo en el directorio raíz de su sitio web.

Herramientas relacionadas

Generador de Robots.txt de ETTVI

Cree el archivo Robots.txt para su sitio web para determinar el comportamiento de los rastreadores de los motores de búsqueda con el Generador Robots.txt de ETTVI. Los webmasters pueden aprovechar esta herramienta para generar un archivo Robots.txt estándar con configuración predeterminada o personalizarlo para establecer instrucciones de rastreo específicas para diferentes páginas web.

Aproveche las funcionalidades de nivel avanzado del Generador Robots.txt de ETTVI para restringir el rastreo de un directorio u ocultar sus páginas privadas del rastreador.

Incluya por separado metadirectivas de robots para cada URL para indicar qué y cómo los rastreadores pueden acceder a los enlaces respectivos sin desperdiciar su presupuesto de rastreo. Permita o no permita que diferentes rastreadores de motores de búsqueda rastreen su contenido web según sea necesario.

Robots.txt Creator de ETTVI procesa eficazmente la información proporcionada para especificar las instrucciones de rastreo sin ningún error de codificación. Informe a los rastreadores sobre cómo deben rastrear e indexar sus páginas web con el Generador Robots.txt de ETTVI de forma gratuita.

¿Cómo utilizar el generador Robots.txt de ETTVI?

El generador Robots.txt de ETTVI permite a los usuarios generar un archivo Robots.txt predeterminado con instrucciones de rastreo "Todos permitidos" o "Todos no permitidos", así como crear un archivo Robots.txt personalizado con funcionalidades adicionales.

Generar un archivo Robots.txt estándar

Siga estos pasos para generar un archivo Robots.txt estándar con la configuración predeterminada:

PASO 1: Establecer metadirectivas para robots

Puede configurar directivas de permitir/no permitir para que "todos los robots de los motores de búsqueda" generen un archivo robots.txt estándar. Elija "Permitir" o "No permitir" para aplicar la configuración predeterminada:

PASO 2: ingrese la dirección del mapa del sitio

Ingrese el enlace al mapa del sitio de su sitio web o déjelo en blanco si no tiene ninguno.

Puede ingresar más de un mapa de sitio específico de una categoría de las páginas, publicaciones, categorías y etiquetas de su sitio web.

PASO 3: Obtenga el código Robots.txt

Justo cuando ingresa la información requerida, el Generador Robots.txt de ETTVI genera y muestra automáticamente el código Robots.txt.

Puede descargar o copiar el código para enviar el archivo Robots.txt al directorio raíz de su sitio web.

Generar archivo Robots.txt personalizado

Siga estos pasos para generar un archivo Robots.txt estándar con la configuración predeterminada:

Introduzca las URL:

PASO 2: seleccione el agente de usuario

Puede configurar directivas de meta robots para cualquiera de los siguientes agentes de usuario:

- imagen de Google

- Google Móvil

- Búsqueda de MSN

- yahoo

- Yahoo MM

- Blogs de Yahoo

- Baidu

- Búsqueda de imágenes de MSN

Puede seleccionar diferentes agentes de usuario para diferentes URL.

PASO 3: Permitir/No permitir robots de motores de búsqueda

Seleccione "Permitir o No permitir" para configurar las metadirectivas de los robots para las URL proporcionadas.

Puede configurar por separado la directiva "Permitir" o "No permitir" para cada URL.

¿Por qué utilizar el generador Robots.txt de ETTVI?

Robots.txt es un archivo que se utiliza para dar instrucciones al rastreador del motor de búsqueda sobre qué URL se pueden rastrear o indexar y cuáles no. El archivo robots.txt es muy importante y beneficioso para los webmasters y cada experto en SEO utiliza el archivo robots.txt para diferentes propósitos.

Sin embargo, si no está escrito correctamente, puede causar problemas de indexación en su sitio y Google no podrá rastrear su sitio web correctamente. Con el generador Robots.txt de ETTVI, puede generar un archivo preciso en lugar de codificarlo manualmente con un solo clic.

Cree rápidamente el archivo Robots.txt

Robots.txt Generator puede salvarlo de cualquier error de codificación y le ahorra mucho tiempo que puede aplicar en otras tareas de SEO como generar un mapa del sitio. La mayoría de los expertos en SEO recomiendan el Generador Robots.txt de ETTVI porque es una herramienta eficiente, rápida y gratuita que creará su archivo robots.txt en poco tiempo según sus necesidades.

Ocultar páginas privadas

Supongamos que tiene una página privada que solo desea mostrar a las personas suscritas, pero si se indexa, todos pueden verla. Entonces, para evitar este problema, debe no permitir sus páginas privadas en robots.txt.

Ahorre presupuesto de rastreo

Si tiene muchas páginas adicionales (etiquetas Me gusta), pueden alterar su presupuesto de rastreo y causar problemas de indexación. Por lo tanto, no permitimos páginas adicionales en robots.txt para evitar este problema.

¿Entiendes Robots.txt?

El archivo Robots.txt es un archivo de texto que contiene información sobre cómo un rastreador debe rastrear un sitio web. Además, puedes especificar a qué áreas no quieres que los rastreadores accedan, por ejemplo, áreas con contenido duplicado o aquellas en construcción. Hay algunos bots que no siguen este estándar, incluidos los detectores de malware y los recolectores de correo electrónico. Como resultado, buscarán puntos débiles en su sistema de seguridad. Si no desea que se indexen ciertas áreas, existe una posibilidad razonable de que comiencen a revisar su sitio web desde esas áreas.

Normalmente hay dos archivos Robots.txt: uno proporciona el "Agente de usuario" y el otro incluye directivas que son "Permitir", "No permitir", "Retraso de rastreo", etc. Escribir manualmente un archivo de líneas de comando puede llevar bastante tiempo. mucho tiempo y el archivo puede contener varias líneas de comandos a la vez. Debes escribir "No permitir: el enlace que no deseas que visiten los bots" en la página siguiente. El mismo método se aplica al comando "permitir".

¿Por qué es importante Robots.txt?

La mayoría de los sitios web no requieren los archivos Robots.txt. Como resultado, Google suele ser capaz de encontrar todas las páginas importantes de su sitio web e indexarlas sin ninguna dificultad. Y no indexarán páginas que no sean importantes ni duplicados de páginas ya indexadas.

Sin embargo, existen tres razones principales para utilizar un archivo robots.txt.

No permita que se vean páginas no públicas. A veces, no desea que determinadas páginas se indexen en su sitio. Es posible, por ejemplo, tener versiones provisionales de determinadas páginas o una página de inicio de sesión. Es imperativo que estas páginas existan y los usuarios aleatorios no deben ser dirigidos a ellas. Por lo tanto, el archivo robots.txt debe usarse para impedir que los rastreadores y bots accedan a estas páginas.

Aproveche al máximo su presupuesto de rastreo. Puede haber un problema de presupuesto de rastreo si tiene dificultades para indexar sus páginas. Cuando utiliza robots.txt para bloquear páginas sin importancia, el robot de Google pasará más tiempo en las páginas web que son realmente importantes.

Los recursos no deben indexarse. Puede utilizar metadirectivas para evitar que una página se indexe con la misma eficacia que si se utilizara un archivo Robot.txt. Sin embargo, las metadirectivas no funcionan bien con recursos multimedia como archivos PDF e imágenes. En este caso, el archivo robots.txt sería útil.

Cuando los robots de los motores de búsqueda examinan archivos, primero buscan el archivo robots.txt y, si no lo encuentran, existe una gran posibilidad de que no se indexen todas las páginas de su sitio. Cuando agrega más páginas, puede modificar el archivo Robot.txt con algunas instrucciones agregando la página principal a la lista de no permitidos. Sin embargo, evite agregar la página principal a la lista de no permitidos al principio del archivo.

Hay un presupuesto para rastrear el sitio web de Google; este presupuesto está determinado por un límite de rastreo. Como regla general, los rastreadores pasarán una cierta cantidad de tiempo en un sitio web antes de pasar al siguiente, pero si Google descubre que rastrear su sitio molesta a sus usuarios, lo rastreará más lentamente. Debido al rastreo más lento de su sitio web por parte de Google, solo indexará unas pocas páginas de su sitio a la vez, por lo que su publicación más reciente tardará en indexarse por completo. Es necesario que su sitio tenga un mapa del sitio y un archivo robots.txt para poder solucionar este problema. El proceso de rastreo se agilizará dirigiéndolos a los enlaces de su sitio que requieren atención especial para acelerar el proceso de rastreo.

Además de tener una tasa de rastreo para un sitio web, cada bot tiene su propia cotización de rastreo única. Por eso necesitas un archivo robot para tu sitio web de WordPress. Esto se debe al hecho de que consta de una gran cantidad de páginas que no son necesarias para la indexación. Además, si elige no incluir un archivo robots.txt, los rastreadores seguirán indexando su sitio web, pero a menos que sea un blog muy grande y contenga muchas páginas, no es necesario.

El propósito de las directivas en un archivo Robot.txt:

Al crear el archivo manual, es imperativo que sepa cómo se debe formatear el archivo. Además, después de aprender cómo funciona, podrás modificarlo.

Retraso en el tiempo de rastreo: al configurar esta directiva, los rastreadores no sobrecargarán el servidor, ya que demasiadas solicitudes harán que el servidor trabaje demasiado, lo que no dará como resultado una experiencia de usuario óptima. Los distintos robots de motores de búsqueda responden de forma diferente a la directiva Crawl-Delay. Por ejemplo, Bing, Google y Yandex responden de manera diferente.

Permitir: Al utilizar esta directiva, permitimos que se indexen las siguientes URL. Independientemente de la cantidad de URL que pueda agregar a su lista, si tiene un sitio web de comercio electrónico, es posible que tenga muchas URL para agregar. Si decide utilizar el archivo robots, sólo debe utilizarlo para las páginas que no desea que se indexen.

No permitir: Una de las funciones más importantes de un archivo Robots es evitar que los rastreadores puedan acceder a enlaces, directorios, etc. dentro del mismo. Sin embargo, otros bots pueden acceder a estos directorios, lo que significa que deben buscar malware porque no cumplen.

Diferencia entre un mapa del sitio y un archivo Robot.txt

Un mapa del sitio contiene información valiosa para los motores de búsqueda y es esencial para todos los sitios web. Los mapas de sitio informan a los robots cuándo se actualiza su sitio web y qué tipo de contenido ofrece. El propósito de la página es informar al motor de búsqueda de todas las páginas que contiene su sitio y que deben rastrearse, mientras que el propósito del archivo robots.txt es notificar al rastreador. A los rastreadores se les dice qué páginas rastrear y cuáles evitar usando Robot.txt. Para que su sitio web sea indexado, necesitará un mapa del sitio, mientras que no se requiere robot.txt.

Preguntas Frecuentes

¿Qué es el archivo Robots.txt?

¿Qué es el generador Robots.txt?

Robots.txt Generator es una herramienta en línea basada en web que permite a los webmasters crear robots.txt personalizados según sus necesidades sin necesidad de codificación manual.

¿Es necesario Robots.txt?

No, un archivo robots.txt no es necesario pero con él puedes tener control sobre los rastreadores de los motores de búsqueda. La mayoría de los expertos recomiendan tener un archivo robots.txt en su sitio web.

¿Cómo creo un archivo Robots.txt?

Puedes crear uno con codificación manual, pero es demasiado peligroso y puede causar problemas de indexación. Entonces, la mejor solución para salvarse de este problema es utilizar un generador Robots.txt como el de Ettvi. El generador Robots.txt de Ettvi le permite crear su propio archivo personalizado de forma gratuita.

¿Cómo validar si My Robots.txt es bueno o no?

Después de generar y colocar Robots.txt, surge una pregunta importante: ¿cómo validar el archivo robots.txt? Puede validar fácilmente su archivo con la herramienta de validación Robots.txt de ETTVI.

Manténgase al día en el mundo del correo electrónico.

Suscríbase para recibir correos electrónicos semanales con artículos seleccionados, guías y videos para mejorar sus tácticas.